Sorun: 2 süreç i ve j verildiğinde, herhangi bir ek donanım desteği olmadan ikisi arasında karşılıklı dışlamayı garanti edebilecek bir program yazmanız gerekir.

CPU saat döngülerinin israfı

Meslekten olmayan terimlerle söylemek gerekirse, bir iş parçacığı sırasını beklerken, koşulu saniyede milyonlarca kez test eden ve böylece gereksiz hesaplama yapan uzun bir döngüyle sona erdi. Beklemenin daha iyi bir yolu var ve buna denir 'teslim olmak' .

Ne yaptığını anlamak için Süreç zamanlayıcının Linux'ta nasıl çalıştığını derinlemesine incelememiz gerekiyor. Burada bahsedilen fikir, zamanlayıcının basitleştirilmiş bir versiyonudur; gerçek uygulamada birçok komplikasyon vardır.

Aşağıdaki örneği göz önünde bulundurun

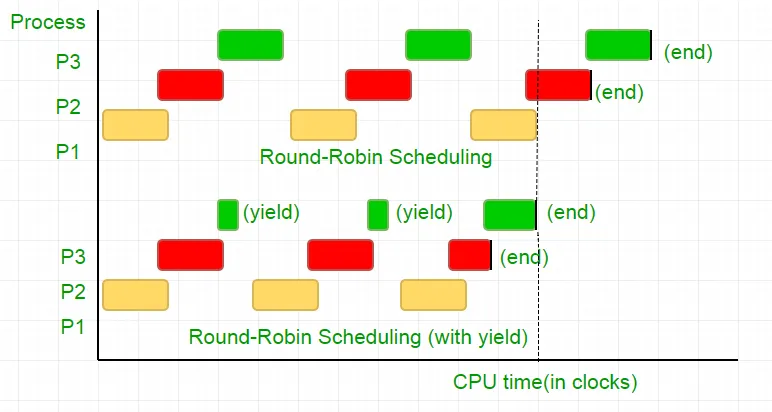

P1 P2 ve P3 olmak üzere üç süreç vardır. P3 süreci, kodumuzdakine benzer bir while döngüsüne sahip olacak ve pek kullanışlı olmayan bir hesaplama yapacaktır ve yalnızca P2 çalışmasını tamamladığında döngüden çıkar. Zamanlayıcı hepsini birer kez deneme sırasına koyar. Şimdi işlemcinin saat hızının 1000000/sn olduğunu ve her yinelemede her işleme 100 saat ayırdığını varsayalım. Daha sonra ilk olarak P1, 100 saat (0,0001 saniye) boyunca çalıştırılacak, ardından P2 (0,0001 saniye) ardından P3 (0,0001 saniye) takip edecek, çünkü artık bu döngü P2 bitene kadar tekrarlanacak ve ardından P3'ün yürütülmesi ve sonunda sona ermesi takip edecek.

Bu, 100 CPU saat döngüsünün tamamen israfıdır. Bunu önlemek için, CPU zaman diliminden, yani bu zaman dilimini esasen sonlandıran verimden karşılıklı olarak vazgeçeriz ve zamanlayıcı, çalıştırılacak bir sonraki işlemi alır. Şimdi durumumuzu bir kez test ediyoruz ve ardından CPU'dan vazgeçiyoruz. Testimizin 25 saat döngüsü sürdüğü göz önüne alındığında, hesaplamamızın %75'ini bir zaman diliminde kaydediyoruz. Bunu grafiksel olarak ifade etmek gerekirse

İşlemci saat hızının 1MHz olduğu düşünülürse bu büyük bir tasarruftur!.

Farklı dağıtımlar bu işlevselliğe ulaşmak için farklı işlevler sağlar. Linux sağlar sched_yield() .

void lock(int self) { flag[self] = 1; turn = 1-self; while (flag[1-self] == 1 && turn == 1-self) // Only change is the addition of // sched_yield() call sched_yield(); }

Bellek çiti.

Önceki eğitimdeki kod çoğu sistemde çalışmış olabilir ancak %100 doğru değildi. Mantık mükemmeldi ancak modern CPU'ların çoğu, sıra dışı yürütmeye neden olabilecek performans optimizasyonları kullanıyor. Bellek işlemlerinin (yüklemeler ve depolamalar) bu şekilde yeniden sıralanması, normalde tek bir yürütme iş parçacığı içinde fark edilmez, ancak eşzamanlı programlarda öngörülemeyen davranışlara neden olabilir.

Bu örneği düşünün

while (f == 0); // Memory fence required here print x;

Yukarıdaki örnekte derleyici 2 ifadeyi birbirinden bağımsız olarak kabul eder ve bu nedenle bunları yeniden sıralayarak kod verimliliğini artırmaya çalışır, bu da eşzamanlı programlar için sorunlara yol açabilir. Bunu önlemek için, derleyiciye bariyerin ötesindeki ifadeler arasındaki olası ilişki hakkında ipucu vermek için bir hafıza çiti yerleştiririz.

Yani ifadelerin sırası

bayrak[kendisi] = 1;

dönüş = 1-kendi;

while (dönüş durumu kontrolü)

teslim olmak();

Kilidin çalışabilmesi için tamamen aynı olması gerekir, aksi takdirde kilitlenme durumuyla sonuçlanacaktır.

Bunu sağlamak için derleyiciler, ifadelerin bu engel boyunca sıralanmasını önleyen bir talimat sağlar. Gcc durumunda __sync_synchronize() .

Böylece değiştirilen kod şöyle olur:

C'de Tam Uygulama:

// Filename: peterson_yieldlock_memoryfence.cpp // Use below command to compile: // g++ -pthread peterson_yieldlock_memoryfence.cpp -o peterson_yieldlock_memoryfence #include

// Filename: peterson_yieldlock_memoryfence.c // Use below command to compile: // gcc -pthread peterson_yieldlock_memoryfence.c -o peterson_yieldlock_memoryfence #include

import java.util.concurrent.atomic.AtomicInteger; public class PetersonYieldLockMemoryFence { static AtomicInteger[] flag = new AtomicInteger[2]; static AtomicInteger turn = new AtomicInteger(); static final int MAX = 1000000000; static int ans = 0; static void lockInit() { flag[0] = new AtomicInteger(); flag[1] = new AtomicInteger(); flag[0].set(0); flag[1].set(0); turn.set(0); } static void lock(int self) { flag[self].set(1); turn.set(1 - self); // Memory fence to prevent the reordering of instructions beyond this barrier. // In Java volatile variables provide this guarantee implicitly. // No direct equivalent to atomic_thread_fence is needed. while (flag[1 - self].get() == 1 && turn.get() == 1 - self) Thread.yield(); } static void unlock(int self) { flag[self].set(0); } static void func(int s) { int i = 0; int self = s; System.out.println('Thread Entered: ' + self); lock(self); // Critical section (Only one thread can enter here at a time) for (i = 0; i < MAX; i++) ans++; unlock(self); } public static void main(String[] args) { // Initialize the lock lockInit(); // Create two threads (both run func) Thread t1 = new Thread(() -> func(0)); Thread t2 = new Thread(() -> func(1)); // Start the threads t1.start(); t2.start(); try { // Wait for the threads to end. t1.join(); t2.join(); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println('Actual Count: ' + ans + ' | Expected Count: ' + MAX * 2); } }

import threading flag = [0 0] turn = 0 MAX = 10**9 ans = 0 def lock_init(): # This function initializes the lock by resetting the flags and turn. global flag turn flag = [0 0] turn = 0 def lock(self): # This function is executed before entering the critical section. It sets the flag for the current thread and gives the turn to the other thread. global flag turn flag[self] = 1 turn = 1 - self while flag[1-self] == 1 and turn == 1-self: pass def unlock(self): # This function is executed after leaving the critical section. It resets the flag for the current thread. global flag flag[self] = 0 def func(s): # This function is executed by each thread. It locks the critical section increments the shared variable and then unlocks the critical section. global ans self = s print(f'Thread Entered: {self}') lock(self) for _ in range(MAX): ans += 1 unlock(self) def main(): # This is the main function where the threads are created and started. lock_init() t1 = threading.Thread(target=func args=(0)) t2 = threading.Thread(target=func args=(1)) t1.start() t2.start() t1.join() t2.join() print(f'Actual Count: {ans} | Expected Count: {MAX*2}') if __name__ == '__main__': main()

class PetersonYieldLockMemoryFence { static flag = [0 0]; static turn = 0; static MAX = 1000000000; static ans = 0; // Function to acquire the lock static async lock(self) { PetersonYieldLockMemoryFence.flag[self] = 1; PetersonYieldLockMemoryFence.turn = 1 - self; // Asynchronous loop with a small delay to yield while (PetersonYieldLockMemoryFence.flag[1 - self] == 1 && PetersonYieldLockMemoryFence.turn == 1 - self) { await new Promise(resolve => setTimeout(resolve 0)); } } // Function to release the lock static unlock(self) { PetersonYieldLockMemoryFence.flag[self] = 0; } // Function representing the critical section static func(s) { let i = 0; let self = s; console.log('Thread Entered: ' + self); // Lock the critical section PetersonYieldLockMemoryFence.lock(self).then(() => { // Critical section (Only one thread can enter here at a time) for (i = 0; i < PetersonYieldLockMemoryFence.MAX; i++) { PetersonYieldLockMemoryFence.ans++; } // Release the lock PetersonYieldLockMemoryFence.unlock(self); }); } // Main function static main() { // Create two threads (both run func) const t1 = new Thread(() => PetersonYieldLockMemoryFence.func(0)); const t2 = new Thread(() => PetersonYieldLockMemoryFence.func(1)); // Start the threads t1.start(); t2.start(); // Wait for the threads to end. setTimeout(() => { console.log('Actual Count: ' + PetersonYieldLockMemoryFence.ans + ' | Expected Count: ' + PetersonYieldLockMemoryFence.MAX * 2); } 1000); // Delay for a while to ensure threads finish } } // Define a simple Thread class for simulation class Thread { constructor(func) { this.func = func; } start() { this.func(); } } // Run the main function PetersonYieldLockMemoryFence.main();

// mythread.h (A wrapper header file with assert statements) #ifndef __MYTHREADS_h__ #define __MYTHREADS_h__ #include

// mythread.h (A wrapper header file with assert // statements) #ifndef __MYTHREADS_h__ #define __MYTHREADS_h__ #include

import threading import ctypes # Function to lock a thread lock def Thread_lock(lock): lock.acquire() # Acquire the lock # No need for assert in Python acquire will raise an exception if it fails # Function to unlock a thread lock def Thread_unlock(lock): lock.release() # Release the lock # No need for assert in Python release will raise an exception if it fails # Function to create a thread def Thread_create(target args=()): thread = threading.Thread(target=target args=args) thread.start() # Start the thread # No need for assert in Python thread.start() will raise an exception if it fails # Function to join a thread def Thread_join(thread): thread.join() # Wait for the thread to finish # No need for assert in Python thread.join() will raise an exception if it fails

Çıkış:

Thread Entered: 1

Thread Entered: 0

Actual Count: 2000000000 | Expected Count: 2000000000